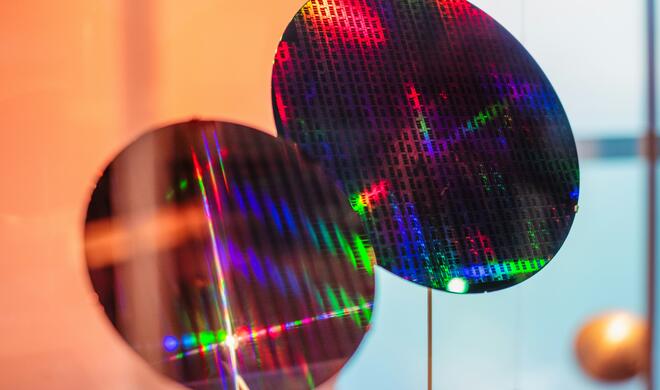

Das geht aus einem Bericht des Online-Magazins 9to5mac hervor und wirft nun natürlich noch mehr Zündstoff in die Debatte um die CSAM-Scans. Der Autor Ben Lovejoy hatte bei Apple nachgehakt und hörte dann verblüffendes – nämlich, dass Apple E-Mails bereits nach Verdachtsfällen hin überprüft und iCloud Mail scannt. Das Scannen der Posteingänge ist im Übrigen nicht unüblich. Google hatte bereits im Jahr 2014 mit der Durchsuchung bei Gmail begonnen und später auf andere Dienste ausgeweitet. Seither veröffentlicht Google auch Zahlen dazu. Laut dem Spiegel findet der Suchmaschinenriese so jährlich 4,5 Millionen Inhalte zu Kindesmissbrauch.

Mehr Apple-Wissen für dich.

Mac Life+ ist die digitale Abo-Flatrate mit exklusiven, unabhängigen Tests, Tipps und Ratgebern für alle Apple-Anwenderinnen und Anwender - ganz egal ob neu mit dabei oder Profi!

Mac Life+ beinhaltet

- Zugriff auf alle Online-Inhalte von Mac Life+

- alle digitalen Ausgaben der Mac Life, unserer Sonderhefte und Fachbücher im Zugriff

- exklusive Tests, Artikel und Hintergründe vorab lesen

- maclife.de ohne Werbebanner lesen

- Satte Rabatte: Mac, iPhone und iPad sowie Zubehör bis zu 15 Prozent günstiger kaufen!

✔ SOFORT gratis und ohne Risiko testen: Der erste Monat ist kostenlos, danach nur 6,99 Euro/Monat.

✔ Im Jahresabo noch günstiger! Wenn du direkt für ein ganzes Jahr abonnierst, bezahlst du sogar nur 4,99 Euro pro Monat.

Die Klarstellung von Apple erfolgte, nachdem der 9to5mac-Autor eine Aussage, dass Apple „die größte Plattform für die Verbreitung von Kinderpornografie“ sei, hinterfragte. Das warf sofort die Frage auf: Wenn das Unternehmen die iCloud-Fotos nicht scannt, wie kann Apple das wissen?

Es gibt auch einige andere Hinweise darauf, dass Apple eine Art von CSAM-Scan durchgeführt haben muss. Eine archivierte Version der Kindersicherheitsseite von Apple erläutert einen „Bildabgleich“. Da heißt es:

„Apple hat sich dem Schutz von Kindern in unserem gesamten Ökosystem verschrieben, wo immer unsere Produkte verwendet werden, und wir unterstützen auch weiterhin Innovationen in diesem Bereich. Wir haben robuste Schutzmaßnahmen auf allen Ebenen unserer Softwareplattform und in unserer gesamten Lieferkette entwickelt. Im Rahmen dieses Engagements setzt Apple eine Technologie zum Bildabgleich ein, um die Ausbeutung von Kindern zu erkennen und zu melden. Ähnlich wie Spam-Filter in E-Mails verwenden unsere Systeme elektronische Signaturen, um mutmaßliche Fälle von Kinderausbeutung zu finden. Jeder Abgleich wird durch eine individuelle Überprüfung bestätigt. Konten mit Inhalten, die der Ausbeutung von Kindern dienen, verstoßen gegen unsere Nutzungsbedingungen, und alle Konten, die wir mit diesem Material finden, werden deaktiviert.“

Apple scannt iCloud Mail

Apple bestätigte aber auch, dass bisher iCloud Fotos nie gescannt wurde. Apple bestätigte gegenüber 9to5mac jedoch, dass seit 2019 ausgehende und eingehende iCloud Mail auf CSAM-Anhänge gescannt werden. E-Mails sind nicht verschlüsselt, sodass das Scannen von Anhängen, während die E-Mails die Apple-Server passieren, „eine triviale Aufgabe wäre“.

Apple wies auch darauf hin, dass es in begrenztem Umfang andere Daten scannt, machte aber keine Angaben, um welche Daten es sich dabei handelt. iCloud-Backups umfasst das aber nicht.

- Test: Das sind die besten Mäuse für den Mac - Spoiler: Es ist nicht die Magic Mouse

- Telefonieren mit dem Mac: Dank Gratis-App in Minutenschnelle möglich

- Ausprobiert: Chromebook statt MacBook Pro – wie gut sind die „Google-Notebooks“?

- Apple Watch SE im Test: Von der Kunst des Weglassens – wer braucht überhaupt die teurere Series 6?

Diskutiere mit!

Hier kannst du den Artikel "Apple scannt iCloud Mail bereits nach sexuellen Kindesmissbrauch" kommentieren. Melde dich einfach mit deinem maclife.de-Account an oder fülle die unten stehenden Felder aus.

finde ich sehr, sehr gut!

Sie sollen ruhig auch politisch Andersdenkende scannen!! Wer brav die richtige Partei wählt und nichts falsches sagt, hat nichts zu befürchten!!! :)

Freiheit ist eben nur dann möglich wenn jeder Einzelne von uns intensiv überwacht wird.

Dummschwätzer.

Ich zeige dich an!

Was, das Clickbait?