Apple wird im Februar 2026 eine neue Version von Siri vorstellen, die auf Google Gemini basiert. Das berichtet Mark Gurman von Bloomberg in seinem wöchentlichen Newsletter „Power On“. Die Präsentation soll in der zweiten Februarhälfte stattfinden, wobei noch unklar ist, ob Apple ein vollständiges Event plant oder private Medienbriefings durchführt.

- Apple präsentiert im Februar 2026 eine neue Siri-Version, die auf Google Gemini basiert und mit iOS 26.4 im März erscheint.

- Die Assistenz greift auf persönliche Daten zu und kann komplexe Aufgaben erfüllen – Apple zahlt Google dafür eine Milliarde US-Dollar jährlich.

- Mit iOS 27 wird Siri zum vollwertigen Chatbot ausgebaut, während Apple parallel an eigenen KI-Modellen arbeitet.

Die neue Siri-Version wird Teil von iOS 26.4 sein, das im Februar als Beta erscheint und voraussichtlich im März oder Anfang April für alle Nutzenden verfügbar sein wird. Damit können alle mit einem iPhone 15 Pro oder neuer die verbesserte Assistenz bereits in wenigen Monaten nutzen.

Lange Entwicklungszeit und technische Herausforderungen

Apple hatte die personalisierten Siri-Funktionen bereits auf der WWDC 2024 angekündigt, musste sie jedoch später verschieben. Die Verzögerung führte dazu, dass das Unternehmen sich an Google wandte. Die überarbeitete Siri läuft technisch gesehen weiterhin auf einem neuen Apple-Intelligence-Modell, in das jedoch Gemini-Technologie integriert ist.

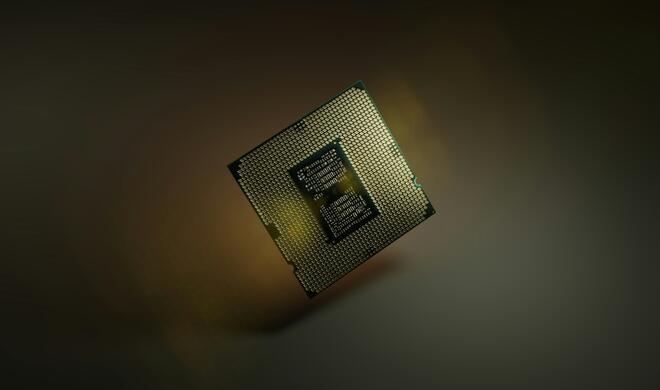

Ein Large Language Model ist ein künstliches neuronales Netzwerk, das mit riesigen Textmengen trainiert wurde und menschliche Sprache verstehen und erzeugen kann. Die Leistungsfähigkeit wird oft in Parametern gemessen – je mehr Parameter, desto komplexere Zusammenhänge kann das Modell erfassen. Modelle wie Google Gemini oder ChatGPT nutzen diese Technologie, um Fragen zu beantworten, Texte zu schreiben oder Aufgaben zu erledigen.

Personalisierung durch Zugriff auf persönliche Daten

Wie Apple bereits gezeigt hat, soll die Assistenz auf persönliche Daten und Bildschirminhalte zugreifen können, um Aufgaben zu erfüllen. Ein Beispiel: Nutzende können Siri nach dem Flug ihrer Mutter und deren Restaurantreservierung fragen – die Assistenz durchsucht dazu die Mail- und Nachrichten-Apps und liefert die entsprechenden Informationen.

Die technische Grundlage bildet ein maßgeschneidertes Gemini-Modell, für das Apple Google etwa eine Milliarde US-Dollar jährlich zahlt. Das Modell nutzt 1,2 Billionen Parameter und übertrifft damit die aktuelle cloud-basierte Version von Apple Intelligence mit 150 Milliarden Parametern deutlich. Die Verarbeitung erfolgt auf Apples Private Cloud Compute-Servern, sodass Google keinen Zugriff auf Nutzerdaten erhält.

Chatbot-Funktionen für iOS 27 geplant

Für iOS 27 plant Apple weitere Verbesserungen. Siri soll zu einem vollwertigen Chatbot werden, der längere Konversationen führen kann – ähnlich wie ChatGPT oder Gemini, jedoch direkt in iPhone, iPad und Mac integriert. Laut Gurman wird dieser Siri-Chatbot „konkurrenzfähig mit Gemini 3“ sein und „deutlich leistungsfähiger“ als die personalisierte Version in iOS 26.4.

Der Chatbot könnte direkt auf Google-Servern laufen. Apple entwickelt parallel eigene KI-Modelle weiter und plant, mittelfristig auf eine hauseigene Lösung umzusteigen, sobald die eigenen Large Language Models leistungsfähig genug sind. Das Unternehmen arbeitet bereits an einem eigenen Cloud-basierten Modell mit einer Billion Parametern, das möglicherweise schon 2026 einsatzbereit sein könnte.

Partnerschaft geht über Siri hinaus

Die Zusammenarbeit zwischen Apple und Google beschränkt sich nicht nur auf Siri. Die Unternehmen gaben bekannt, dass Google Gemini künftig eine Reihe von Apple-Intelligence-Funktionen unterstützen wird. Details zu spezifischen Features nannten sie jedoch nicht. Unklar bleibt, ob Gemini auch bestehende Apple-Intelligence-Funktionen wie Schreibtools, Image Playground oder Benachrichtigungszusammenfassungen antreiben wird.

Apple betont, dass Apple Intelligence weiterhin auf Apple-Geräten und den Private Cloud Compute-Servern des Unternehmens läuft und branchenführende Datenschutzstandards einhält. Die Partnerschaft mit Google ist Teil einer mehrjährigen Zusammenarbeit, bei der die nächste Generation von Apple Foundation Models auf Gemini-Modellen und Cloud-Technologie von Google basieren wird.

Vor der Entscheidung für Google hatte Apple auch Gespräche mit OpenAI und Anthropic geführt. Beide Unternehmen entwickelten Versionen ihrer Modelle für Apples Server. Letztlich fiel die Wahl auf Google, unter anderem weil Anthropics Gebühren als zu hoch eingestuft wurden. Die beiden Unternehmen verbindet bereits eine langjährige Partnerschaft: Google zahlt Apple rund 20 Milliarden US-Dollar pro Jahr, um die Standard-Suchmaschine auf Apple-Geräten zu sein.